Im Unterschied zu natürlichen Sprachen, die sich irgendwann im Laufe der Menschheitsgeschichte entwickelt haben1, werden Plansprachen (auch konstruierte Sprachen genannt) von einzelnen Menschen oder Gruppen entworfen. Der Entwurf solcher Plansprachen kann auf unterschiedliche Beweggründe zurückgeführt werden; der bekannteste ist wohl die Erleichterung der Kommunikation über die Grenzen natürlicher Sprachen hinweg durch die Erschaffung einer künstlichen Lingua Franca. Esperanto - 1887 vom polnischen Augenarzt und Philologen Ludwig Zamenhof vorgestellt – dürfte wohl jeder Leserin bzw. jedem Leser ein Begriff sein. Es ist allerdings nur einer von mehreren Ansätzen, eine künstliche Sprache zu schaffen, die als Kommunikationsmittel für die gesamte Weltgemeinschaft dienen könnte.

Das Vokabular des Esperanto besteht zum großen Teil aus Entlehnungen aus romanischen Sprachen, ein Teil lässt sich aber auch auf germanische und slawische Ursprünge zurückführen. Zur leichten Erlernbarkeit setze Zamenhof auf strenge Regularitäten, z.B. eine phonematische Schriftweise (jedem Laut wird genau ein Schriftzeichen zugeordnet bzw. linguistisch korrekt: jedem Phonem entspricht genau ein Graphem); die Wortbildung ist an agglutinierende Sprachen (z.B. Türkisch) angelehnt, wo Sinneinheiten (linguistisch: sprachlichen Konzepten) eindeutige Wortbestandteile (linguistisch: Morpheme) zugeordnet sind. So ist ein Wort, das auf -o endet, immer ein Substantiv, eins auf -a immer ein Adjektiv. Durch Anhängen von -j kann man den Plural bilden, durch Vorsetzen von mal- verneinen:

- la bela Blogo – der schöne Blog

- la malbenaj Blogoj – die nicht schönen Blogs

Zamenhof bediente sich also des Vokabulars verschiedener natürlicher Sprachen und versuchte, die Grammatik weitestgehend zu systematisieren. Solche artifiziellen Sprachkonstrukte, die sich an natürlichsprachlichen Vorbildern orientieren, nennt man auch Plansprachen a posteriori. Sie werden unterschieden2 von Plansprachen a priori, die sich in erster Linie an anderen Konzepten (z.B. Logik, Kategorienlehre) anlehnen.

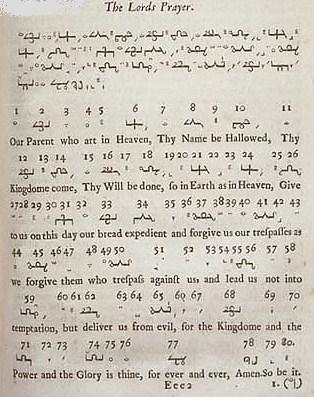

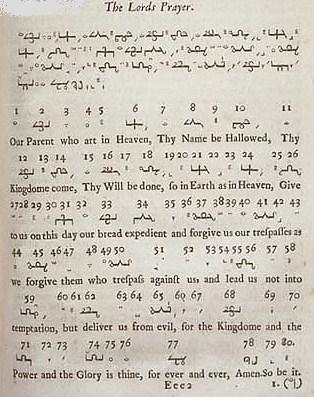

Solche a-priori-Plansprachen können u.a. philosophisch inspiriert sein, wenn z.B. die natürliche Ordnung der Dinge in der Sprache widergespiegelt werden soll. Einen solchen Ordungsversuch unternimmt etwa der anglikanische Geistliche und Naturphilosoph John Wilkins, niedergelegt in seinem “Essay towards a Real Character and a Philosophical Language” von 1668.3 Dafür musste er zunächst grundlegende Begriffsvorstellungen klassifizieren. Für diese klassifizierten Grundideen entwickelt er eine Begriffsschrift, bei der Grundkonzepte aus wenigen Linien bestehen, Untergattungen dann jeweils noch weitere Striche hinzufügen. Daraus resultiert, dass ähnliche Konzepten (die aus den gleichen Obergattungen abgeleitet sind) ähnliche Schriftzeichen zugeordnet werden. In der Übersetzung des Vater unser (Abbildung unten) ist zu sehen, dass sich “Earth” (Zeichen 22) von “Heaven” (24) nur durch einen zusätzlichen Querstrich rechts am Zeichen unterscheidet. Beide sind aus dem Zeichen für “World”, das ähnlich wie ein Additionszeichen (+) aussieht, abgeleitet. “Power” (71) und “Glory” (74) sind, nach ihren Zeichenkörpern zu urteilen, ebenfalls verwandte Konzepte für Wilkins, wie auch (etwas etwas weiter voneinander entfernt) “trespass” (50) und “evil” (65).

Eine grundlegende Eigenschaft natürlichsprachlicher Zeichen ist die willkürliche (arbiträre) Zuordnung von Bezeichnendem (oder Zeichenkörper, Ausdruck, Signifiant) zu Bezeichnetem (oder dahinterstehendem Konzept, Inhalt, Signifié). Wilkins scheint daran gelegen zu haben, diese Willkür weitestgehend aufzuheben bzw. stringenter zu systematisieren, hin zu einem Isomorphismus zwischen Ausdruck und Inhalt. Das Resultat sollte eine nahezu perfekte Sprache sein, durch die Wahrheiten ausgedrückt oder sogar berechnet werden könnten, die sich in natürlichen Sprachen nicht ausdrücken bzw. automatisch berechnen lassen.

Mir ist nicht bekannt, ob jemals wer in der von Wilkins entworfenen Universalsprache tatsächlich korrespondiert hat – für die Zeichen waren keine verbalen Entsprechungen vorgesehen, ein mündlicher Austausch war daher ohnehin ausgeschlossen. Die Aufhebung der arbiträren Zuordnung zwischen Signifiant und Signifié dürfte allerdings im alltäglichen Gebrauch Probleme bereiten: Sprachsignale werden nie perfekt übertragen, auch in der schriftlichen Kommunikation kann es zu Schreibfehlern, Undeutlichkeiten, Verschmutzungen etc. kommen. In einer Sprache, wo ähnliche Signifiants völlig unterschiedlichen Signifiés zugeordnet sind (wie in natürlichen Sprachen), dürfte eine Disambiguierung (linguistisch für die Auflösung von Mehrdeutigkeiten) über den Kontext sehr viel erfolgreicher verlaufen, als in Sprachen, in denen ähnliche Zeichen auch ähnliches bedeuten (wie in Wilkins Sprachkonstrukt).

Der Universalsprachentwurf nach Wilkins hatte mit noch mehr Problemen zu kämpfen, insbesondere stellte die Klassifikation aller denkbaren (und damit potentiell in der Sprache zu verwendenden) Dinge Wilkins vor schwer bewältigbare Herausforderungen.4 Dennoch empfand ich die Beschäftigung mit ihr als lohnend, nicht zuletzt, weil viele der seltsamen Eigenschaften des Textes meines Lieblingsforschungsobjektes (dem Voynich Manuskript) durch einen ähnlichen Sprachentwurf erklärt werden könnten. Diese Idee hatte bereits einer der angesehensten Kryptoanalytiker des 20. Jahrhunderts, der Amerikaner William F. Friedman.5 Problematisch an dieser Hypothese war nur, dass das Voynich Manuskript mit einiger Sicherheit schon zu Beginn des 17. Jahrhunderts in Prag kursierte, die ersten Plansprachen a priori aber scheinbar erst über ein halbes Jahrhundert später entworfen wurden (George Dalgarno 1661 und eben Wilkins 1668). Vor kurzem konnte aber gezeigt werden, dass bereits zum Anfang des 16. Jahrhunderts Methoden niedergelegt wurden, deren Anwendung etwas erzeugt, das den Eindruck erwecken kann, ein Text eines Universalsprachentwurfs zu sein, in Wirklichkeit aber ein Chiffrentext ist. Aber dazu hab ich ja schon mal was geschrieben.

So, von den zwei Versprechen, die ich im letzten Post gab, habe ich jetzt das erste eingelöst und damit das andere auch ein wenig wegprokrastiniert. Aber auch da geht es voran. Gut Ding will Weile haben…

______________________________

1 Niemand weiß so genau, zu welchem Zeitpunkt der Mensch anfing, seine Sprache, die sich wahrscheinlich grundlegend von Tierkommunikationssystemen unterscheidet (ich schrieb darüber), auszubilden. Ist vielleicht mal einen eigenen Post wert.

2 Diese Unterscheidung wurde schon 1903 in der Histoire de la langue universelle von Couturat und Leau vorgenommen.

3 Leider habe ich online keine vollständige Ausgabe gefunden – vielleicht hat ja jemand mehr Glück und schickt mir den Link, dann kann ich ihn einbauen. Müsste sich aber wohl um Bilder handeln – da im Original sehr viele Stammbäume abgedruckt sind, düften automatische OCR-Scans Probleme haben.

4 Der Versuch der Sammlung und Kategorisierung aller Konzepte durch Wilkins und seine Mitstreiter, die er in der Royal Society gewann/zwangsverpflichtete, wird sehr anschaulich im Roman Quicksilver, dem ersten Teil des Baroque Cycle von Neal Stephenson beschrieben.

5 Den Gepflogenheiten eines Kryptologen entsprechend hinterließ Friedman seine Vermutung in einem in einer Fußnote verstecktem Anagramm, das viel zu lang war, als dass man es hätte lösen können: “I put no trust in anagrammic acrostic cyphers, for they are of little real value – a waste – and may prove nothing -finis.” Nach seinem Tod war Elizebeth Friedman, seine Witwe und ebenso eine bekannte Kryptoanalytikerin, so gut, die Welt aufzuklären: “The Voynich MSS was an early attempt to construct an artificial or universal language of the a priori type. – Friedman.”

Quelle: http://texperimentales.hypotheses.org/968