|

| Tarquinius Superbus |

|

| Tarquinius Thronergreifung, Comic aus den 1850er Jahren |

|

| Michaelangelos Darstellung der Sibyll |

|

| Lucius Junius Brutus |

|

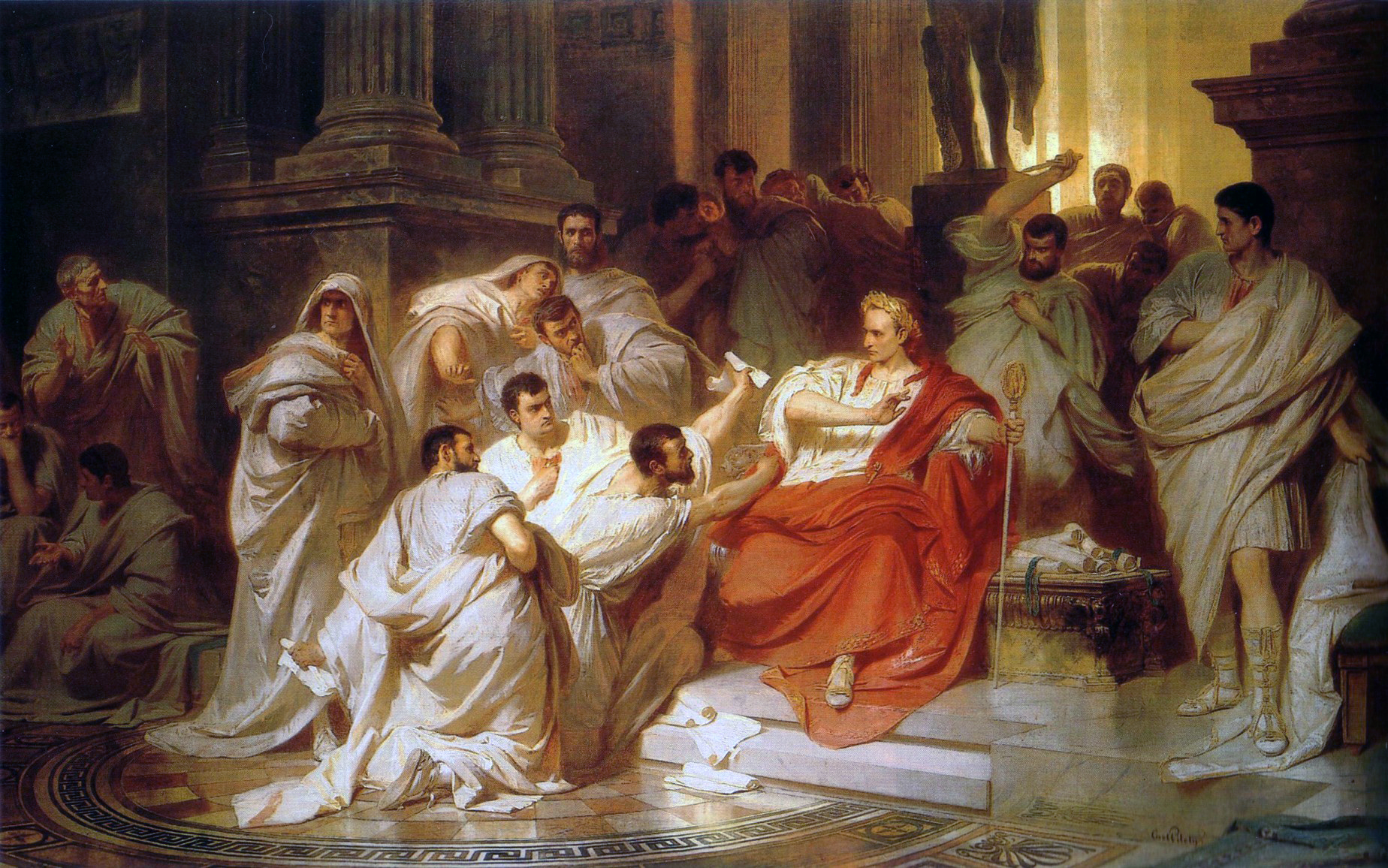

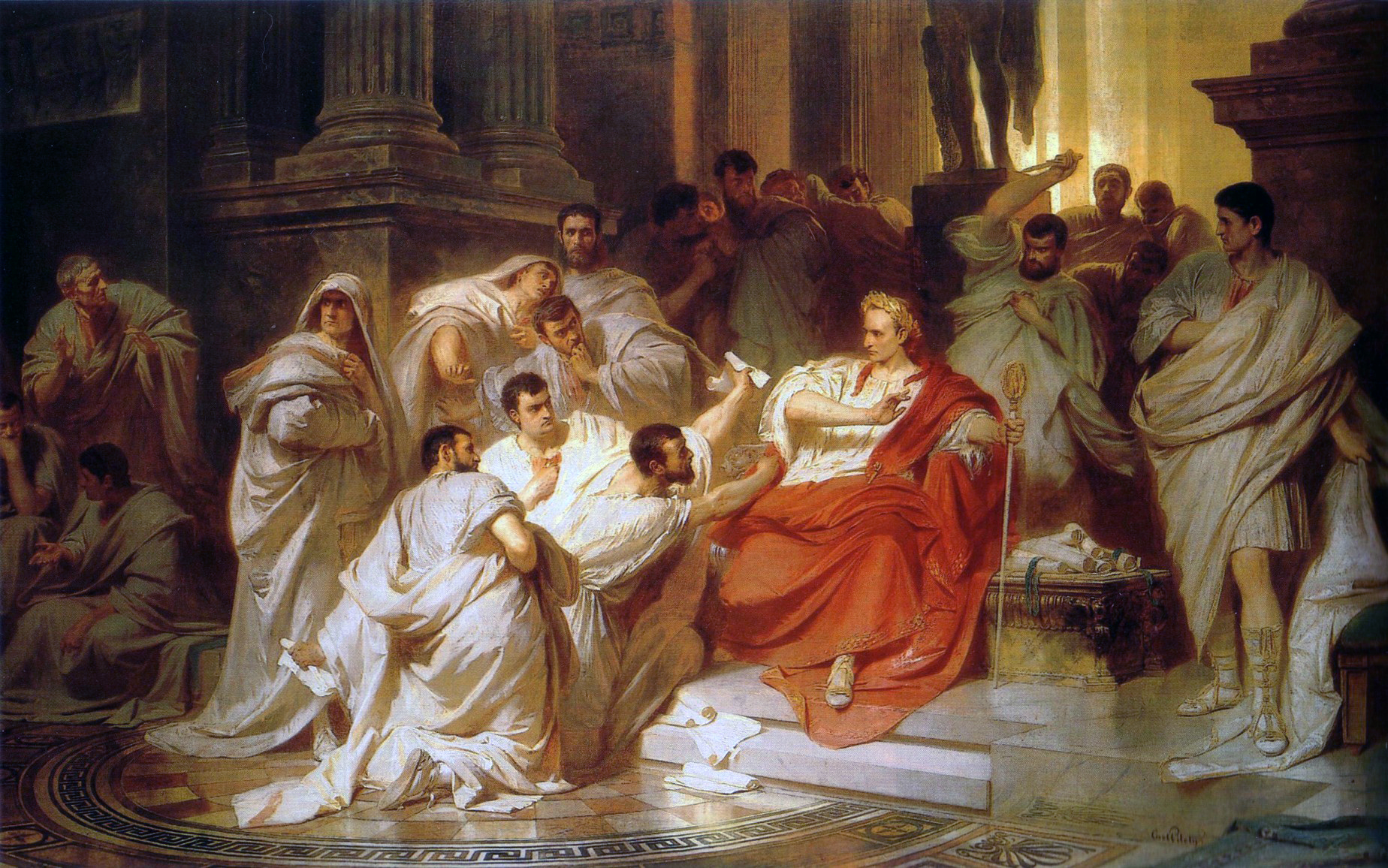

| Tyrannenmord |

Quelle: http://geschichts-blog.blogspot.com/2014/11/legende-und-geschichte-die-romische.html

Geschichtswissenschaftliche Blogs auf einen Blick

|

| Tarquinius Superbus |

|

| Tarquinius Thronergreifung, Comic aus den 1850er Jahren |

|

| Michaelangelos Darstellung der Sibyll |

|

| Lucius Junius Brutus |

|

| Tyrannenmord |

Quelle: http://geschichts-blog.blogspot.com/2014/11/legende-und-geschichte-die-romische.html

Die Projektverbünde TextGrid und DARIAH-DE veranstalten einen DH-Summit 2015 vom 3. bis 4. März 2015 in Berlin (Harnack-Haus).

Das Event richtet sich in erster Linie an die DH-Projekte, Zentren und Nachwuchsgruppen aus den letzten beiden BMBF-Calls sowie weitere assoziierte Projektpartner von TextGrid und DARIAH-DE.

Für das Veranstaltungsprogramm konnten hochkarätige Vertreter aus den Digital Humanities gewonnen werden, so werden die Keynotesprecher Prof. M. Thaller, Universität zu Köln und Dr. K. Fendt, Massachusetts Institute of Technology bespielsweise eine Bestandsaufnahme bzw. Notwendigkeiten und Bedingungen der Digital Humanities präsentieren, geplant sind zudem zwei Panels zu den Perspektiven aus Sicht der Wissenschaft, Infrastruktureinrichtungen und Förderinstitutionen sowie Pro- und Contrapositionen zum Thema Zukunft mit Tradition in den Geisteswissenschaften.

Flankierend sind weitere Veranstaltungen vorgesehen, unter anderem eine TextGrid Grand Tour (6. TextGrid Nutzertreffen) am 5. März 2015.

Alle Informationen rund um das Veranstaltungsprogramm gibt es auf unserer Website www.dhsummit2015.de

Quelle: http://dhd-blog.org/?p=4331

Der Einsatz von Tablets und Smartphones bietet spannende neue und jugendgemäße Methoden für die historische Bildung.

Quelle: http://lernen-aus-der-geschichte.de/Online-Lernen/content/12142

Seit dem Zweitligaaufstieg der Lilien machen sich zweiwöchentlich über zehntausend Menschen auf dem Weg zum Böllenfalltor um zweiundzwanzig Menschen beim Bewegen eines Lederballes mit den Füßen zu beobachten. An solchen Spieltagen wird das Stadion ganz besonders sichtbar. Doch welchen Ort haben Stadien und Sportstätten in Städten in historischer Perspektive?

Dieser Frage ging der viele Jahre am Institut für Geschichte beschäftigte Historiker PD. Dr. Noyan Dinckal aus Paderborn in einem Vortrag im Rahmen des 29. Darmstädter Sport-Forums nach. Er betrachtete dabei die Entwicklung moderner Sportstätten zu Beginn des 20. Jahrhunderts und konstatierte zum einen, wie diese mit zunehmender Popularisierung zunehmenden Einfluss auf den urbanen Raum nahmen. Straßenbahnanschlüsse, Erdumwälzungen, Parkplätze mussten gebaut oder bewältigt werden und wirkten so in starkem Maße auf die Kommune zurück. Zum anderen wurden die Stadien durch das zunehmende Interesse der Bevölkerung zu „Orten architektonischer Massenkultur und urbaner Riten“, wie Dinckal betonte.

Die zunehmende Bedeutung des Zuschauersports brachte begleitende Diskussionen hervor, die auch dem heutigen Ohr bekannt vorkommen. Schon damals gab es Debatten über Gewalt auf den Rängen, über die Rolle von Kommerz im Stadion (auch damals gab es Logen), über die durch das Stadion herbeigeführte Trennung von Profi- und Breitensport und über das Stadion als Prestigeobjekt für die Kommunen.

Ein Blick in die Geschichte des Stadionbaus eröffnet so neue Einblicke auch in aktuelle Diskussionen um Stadionneubauten. Manche Argumentationslinien wirken in historischer Dimension anders, andere Argumente können mit historischen Erfahrungen angereichert werden. Dinckals Vortrag regt auf jeden Fall zum Nach-, Mit- und Andenken an –gerade auch wenn man sich am Wochenende mal wieder auf den Weg ins Stadion am Böllenfalltor macht und dessen Zukunft im Halbzeitgespräch thematisiert wird.

Weiterführende Links:

Verlagsinformation zu Dinckals Buch über Sportlandschaften

Quelle: http://mgtud.hypotheses.org/150

gemeldet von Dr. Harald Klinke M.Sc., Institut für Kunstgeschichte, LMU München

The Digital Age has revolutionized economy, society and our private lives. For decades now, digitalization has also touched most branches of the humanities. With the rising importance of the so called Digital Humanities, Art History is about to change significantly. Since the slide library is irreversibly replaced by image databases, the fact that our media have turned digital opens up to new possibilities. Academic books and journals are increasingly accessed and published via internet. Data-driven approaches enable us to visualize large data-sets and big image data. Computer vision, gamification and citizen science spur new epistemic approaches.

The Digital Age has revolutionized economy, society and our private lives. For decades now, digitalization has also touched most branches of the humanities. With the rising importance of the so called Digital Humanities, Art History is about to change significantly. Since the slide library is irreversibly replaced by image databases, the fact that our media have turned digital opens up to new possibilities. Academic books and journals are increasingly accessed and published via internet. Data-driven approaches enable us to visualize large data-sets and big image data. Computer vision, gamification and citizen science spur new epistemic approaches.

Many such approaches are currently evolving in the international sphere of Art History. Those ideas and projects are in need of a platform of interchange and discourse. A discourse that is linked to Digital Humanities, but regards the special interests and needs of Art History as a historical image science at the interface to Information Science. Thus, the “International Journal of Digital Art History” (DAH) will give authors in this field the opportunity to reach a wider audience, spark a discussion on the future of our discipline and generate an international and interdisciplinary network of scholars and practitioners.

This is a call for manuscripts. The first issue of DAH is scheduled for early 2015. It will focus on the definition of “Digital Art History” in relation to “non-digital”, to information science and general DH. It will encompass the range of the field and its vector into the future. It will also highlight exceptional projects and feature book reviews.

Featured author will be Lev Manovich. He is Professor at The Graduate Center, CUNY, and a Director of the Software Studies Initiative that works on the analysis and visualization of big cultural data.

Manuscripts may be sent to the editors Harald Klinke and Liska Surkemper (editors@dah-journal.org) by Jan, 30 2015. For more information for authors, please visit “Information for Authors”.

ISSN-Print 2363-5398

ISSN-Internet 2363-5401

Quelle: http://dhd-blog.org/?p=4327

Ich wurde neulich mit einer interessanten Ansicht konfrontiert, die mich zum Nachdenken angeregt hat: Kurz nachdem ich mir meinen Montagsfrack angezogen habe und kurz bevor ich bemerkte, dass ich vergessen hatte, Schuhe dazu anzuziehen, geriet ich in eine Meinungsverschiedenheit über den Besitzanspruch eines Sackes Kartoffeln am Markt. Jemand riet mir dort im Handgemenge, ich solle die Situation doch nicht gänzlich aufgrund meiner moralischen Standards bewerten. Denn diese wären naturgemäß (so die Implikation) für jemanden der sich mit Philosophie beschäftige, sehr hoch, vielleicht sogar ideal und deshalb zu hoch, zu lebensfern (wie mein Scheitel an jenem unheivollen Tag).

Denkwürdig ist dieser Rat aber allemal: Erstens enthält er nämlich die Meinung, dass Philosophen gerade nicht die Realität im Auge haben, sondern ein von der Realität losgelöstes Konzept untersuchen. Dieses Konzept würde dann über die nicht-ideale Lebenswirklichkeit gestülpt und passe deshalb nur bedingt. Philosophie sei also weltfremd. - Aber wenn dies der Fall wäre, dann müsste man auf eine andere, nicht-philosophische Meinung rekurrieren, welche vermeintlich näher an der Realität dran wäre. Das hätte die paradoxe Konsequenz zur Folge, dass eine Person, die sich weniger mit der Theorie der Moral beschäftigte, eine bessere moralische Bewertung vornehmen könnte als eine Person, die sich viel damit beschäftigte (ja, Vergangenheit, nicht Konjunktiv). Derselbe Vorwurf scheint bei Juristen bezüglich Rechtsstreitigkeiten, Betriebswirtschaftswissenschaftlern bezüglich betriebswirtschaftlicher Fragen oder Biologen bezüglich anderer Biologen unplausibel, warum also anders bei der Philosophie? "Ja, genau, warum?". Wir sollten tatsächlich immer die Realität, die Wahrheit im Auge haben und kein dünnes Abbild der Wirklichkeit, das in seiner Gültigkeit reduziert ist.

Zweitens denke ich aber tatsächlich nicht, dass Philosophen selbst grundsätzlich moralisch besser dastehen als Juristen, Wirtschaftswissenschaftler und Biologen. „Warum?“ Naja, es gibt viele Gründe: Beispielsweise ist die Bewertung einer Situation im Nachhinein eine ganz andere Sache als die Anwendung der Theorie auf die eigene Handlungsmotivation (Stichwort: Fußball). „Warum?“ Ist doch klar: Solange der Unterschied zwischen einer moralischen und einer amoralischen Handlung im Bruchteil einer Sekunde getroffen wird, während der also keine Zeit zum Abwägen und Durchdenken ist, müsste Ihr moralisches Reflexsystem bereits so gut geschult sein, dass es im Notfall auch ohne langes Nachdenken funktionieren kann. Wie häufig moralische Reflexe zur Anwendung kommen (, ob es sie gibt, was der Unterschied zur plötzlichen Erkenntnis) und wie häufig Zeit zum Denken ist, kann ich Ihnen leider nicht genau sagen.

Selbst wenn aber Aristoteles aus Menschen keine hirnlosen Tugendmaschinen machen wollte, sagte er dennoch zurecht, dass der gute Mensch das Gute gerne tut. Er hat Lust am Guten. Wenn sich Ihnen also der Magen verdreht, wenn Sie eher jemanden vor dem Ertrinken retten sollen, als Ihren Scheitel bei Coiffeur nachziehen zu lassen, sind Sie nach Aristoteles noch nicht tugendhaft.

„Wenn sonach die Tugend zweifach ist, eine Verstandestugend und eine sittliche Tugend, so entsteht und wächst die erstere hauptsächlich durch Belehrung und bedarf deshalb der Erfahrung und der Zeit; die sittliche dagegen wird uns zuteil durch Gewöhnung [...].“ (Aristoteles, Nikomachische Ethik Buch II, Kapitel 1).

Jetzt wollen Sie sicher wissen, wie die Geschichte mit dem Kartoffelsack ausgegangen ist. Ich sage es Ihnen: Als ich mich kurz bückte, um meine Schnürsenkel zuzubinden, da es mir an den Füßen kalt zu sein schien, zog mein Gegner mir einen passenden Scheitel mit seiner Handkante, nahm den Kartoffelsack weg und bestellte schöne Grüße aus dem Naturzustand.

Zwei Bücher haben in letzter Zeit das Thema soziale Ungleichheit und Kapitalismus aufs Tapet gebracht und Feuilleton- und WirtschaftsjournalistInnen umgetrieben. David Graeber zielte mit seinem Buch über „Schulden. Die ersten 5000 Jahre“ auf die ganz großen Kontinuitäten der Menschheitsgeschichte und versuchte, der Welt „ewig Weh und Ach / So tausendfach / Aus einem Punkte“ zu erklären. Das ist intellektuell anregend, aus der gewohnheitsmäßig kleinlichen Sicht des Historikers aber methodisch und theoretisch angreifbar. Angreifbar machte sich auch Thomas Piketty mit seinem „Le Capital au XXIe […]

Kernfrage dieses Artikels ist die grundsätzliche Wählbarkeit von Emotionen und der daraus folgenden Möglichkeit, Emotionen als eigenen Gegenstand von rationalen Entscheidungen zu betrachten. Dazu werden zwei zentrale Theorien der Emotionssoziologie miteinander verglichen: das Emotionskonzept nach Jon Elster und die Theorie … Continue reading →

Kernfrage dieses Artikels ist die grundsätzliche Wählbarkeit von Emotionen und der daraus folgenden Möglichkeit, Emotionen als eigenen Gegenstand von rationalen Entscheidungen zu betrachten. Dazu werden zwei zentrale Theorien der Emotionssoziologie miteinander verglichen: das Emotionskonzept nach Jon Elster und die Theorie … Continue reading

Why is it that of all the mental diseases on record we are so preoccupied with those occurring at the beginning and at the end of life? The Attention Deficit Hyperactivity Disorder (ADHD) and dementia have both attracted the attention of the medical …

Why is it that of all the mental diseases on record we are so preoccupied with those occurring at the beginning and at the end of life? The Attention Deficit Hyperactivity Disorder (ADHD) and dementia have both attracted the attention of the medical profession and the wider public only comparatively late in history. Many a physician has even dared to claim that these disorders were not discovered but as it were invented in the past century.

Even if there is no doubt from my point of view that the mental phenomena known as ADHD and dementia describe a disease, the frequency with which both are diagnosed and discussed is striking. This is not least a question of perspective. It might be said that ADHD and dementia are diagnoses that chiefly serve to identify their sufferers as afflicted with an individual divergence from a cognitive norm. ADHD occurs in young people unable to sit still so as to concentrate on performing a mental task. Older people suffer from dementia when they are neither able to remember things adequately enough nor orient themselves sufficiently well in their everyday lives. Put briefly, both kinds of sufferers experience a painful difference between the demands placed on their mental faculties and actual reality. But this perspective threatens to overly pathologise individual variations on growing up and aging. If my child does not show signs of partial performance inefficiency or a minor form of autism, it must be either highly gifted or otherwise something must be fundamentally wrong. In old age, I become depressed if I am no longer able to learn another language or participate in a new digital technology.

It is time to question such social demands. They result from a collective cognitive bias, which is nothing but a mental distortion of its own kind. Could it be that our pedagogical agendas and curricula have long been overloaded, leaving too little time and space for children to engage fruitfully in emotional and physical learning experiences? And doesn’t the same hold true for the elderly? The overrated fear of developing dementia stems from the notion that we cease to exist when our mind weakens, instead of emphasising that those suffering from this disorder are still (but differently) capable. This is not solely a question about medical prevention and therapy but also about how society deals with these phenomena. Psychological medicine has long become an accomplice of a movement that overly pathologises and medicalises cognitive weaknesses at life’s beginning and end. This goes along with the materialistic tendency of such medicine, a materialism that manifests itself not only in neurobiological terms but also in psychopharmacological and economic ones. ADHD and dementia research mainly endorse brain research, especially in terms of neurofeedback and cognitive training, while neglecting psychotherapeutic approaches well-grounded in the humanities. The driving force behind science and public perception are not least pharmacological options, which assume scary inflationary proportions in the case of ADHD and which are still outstanding, but eagerly awaited, in the case of dementia. Finally, the cult of cognition has something to do with our fear of losing control. The notion that we cannot control our thinking for the entire duration of our lives obviously humiliates us beyond measure. At the end of the day, this humiliation also manifests itself in our efforts to come to grips with this fundamental predicament, for instance, with the help of reproductive medicine and euthanasia.

The development just outlined ultimately seems to follow the impulse to extend adult life, and the full possession of mental faculties throughout its course, as far backwards and forwards as possible. Apart from the question whether this desire follows an economic agenda, it appears to be a dead end. Neuropsychologically, the cognitive development of adolescents rests on mastering physical and emotional developmental tasks. As regards old age, it is reasonable if our memory for novelty weakens in favour of a concentration on the past and reflecting on the here-and-now of the time left. That our thinking capacity is limited is a physiological rather than a pathological fact. By no means do I mean to romanticise ADHS and dementia, whose severe forms are extremely painful for patients and their relatives. From my point of view, however, a considerable amount of suffering from these disorders stems from society’s tendency to overrate the importance of cognition and to overly fear its impairment. Firstly, this leads to diagnosing these illnesses too early and too often. Secondly, we thereby mobilise too many resources to align ourselves and our relatives with a cognitive norm, rather than creating individual scopes of development that take into account the different needs and demands of the young and the elderly.

When parents fight against their children’s ADHD diagnosis, and when adult children fight against their parents’ diagnosis of dementia, basic human perspectives sometimes are obscured from view. If a child’s environment is too focused on aligning that child with a cognitive norm, it will not feel unconditionally loved and welcome. And if attention centres exclusively on cognitive deficits when dealing with a demented person, then relatives will miss the chance to engage with the sufferer’s resources and thereby to maintain a relationship with that person. In human terms, we find ourselves wanting at the beginning and at the end of life. So presumably only those who cherish and preserve their sensory experience of nature and culture throughout adult life can be good companions for the young and the old. Probably, this is also the best preparation for one’s own dementia.

____________________

Literature

External Links

____________________

Image credits

© Bert te Wildt 2014 (private shot).

Recommended citation

te Wildt, Bert: Suffering from the collective cult of cognition. In: Public History Weekly 2 (2014) 41, DOI: dx.doi.org/10.1515/phw-2014-2709.

Copyright (c) 2014 by De Gruyter Oldenbourg and the author, all rights reserved. This work may be copied and redistributed for non-commercial, educational purposes, if permission is granted by the author and usage right holders. For permission please contact: julia.schreiner (at) degruyter.com.

Wie kommt es, dass uns von allen psychischen Erkrankungen seit Jahren diejenigen am meisten beschäftigen, die den Lebensanfang und das Lebensende betreffen? Die Aufmerksamkeitsdefizit- und Hyperaktivitätsstörung (ADHS) und die Demenzerkrankungen haben miteinander gemeinsam, dass sie erst relativ spät ins Rampenlicht von Medizin und Öffentlichkeit gerückt sind. Manch ein Psychiater hat sich sogar zu der Behauptung verstiegen, dass sie nicht im vergangenen Jahrhundert entdeckt, sondern quasi erfunden wurden.

Wenngleich es aus meiner Sicht keinen Zweifel daran gibt, dass die mentalen Phänomene, die wir als ADHS und Demenz umschreiben, von Krankheitswert sind, so lässt doch die Häufigkeit, mit der sie diagnostiziert und diskutiert werden, aufhorchen. Dies ist nicht zuletzt eine Frage der Perspektive. Man könnte meinen, dass die Diagnosen ADHS und Demenz vor allem auch dazu dienen, dem Leiden an einer individuellen Differenz zu einer kognitiven Norm Ausdruck zu verleihen. ADHS betrifft zuallererst junge Menschen, die nicht ausreichend stillsitzen, um konzentriert etwas gedanklich verfolgen zu können. Unter Demenz leiden ältere Menschen, wenn sie sich nicht mehr gut genug erinnern und orientieren können, um sich im Leben zurechtzufinden. Es geht bei beiden um eine schmerzhafte Differenz zwischen Anspruch und Wirklichkeit im Hinblick auf Denkleistungen. Damit drohen individuelle Varianten des Heranwachsens und Alterns übermäßig pathologisiert zu werden. Wenn mein Kind nicht zumindest eine Teilleistungsschwäche oder eine Form von Autismus hat, muss es hochbegabt sein, andernfalls kann bei ihm oder ihr etwas grundsätzlich nicht stimmen. Und im hohen Alter stürzt es mich in eine Depression, wenn ich nicht dazu in der Lage bin, noch eine weitere Sprache zu lernen oder an noch einer neuen digitalen Technologie teilzuhaben.

Es ist Zeit, diese gesellschaftlichen Ansprüche grundsätzlich in Frage zu stellen. Sie folgen einem kollektiven kognitiven Bias, einer gedanklichen Verzerrung der besonderen Art. Sind nicht die Lehrpläne für Schüler längst überfrachtet, und lassen sie nicht zu wenig Zeit-Räume für emotionale und körperliche Lernerfahrungen? Und gilt das mit umgekehrten Vorzeichen nicht ebenso für Menschen im Alter? Die überzogene Angst vor Demenz entspringt der Vorstellung, dass wir aufhören zu existieren, wenn unser Verstand nachlässt, anstatt zu betonen, wozu Menschen trotz Demenz in der Lage sind. Es geht hierbei nicht allein um medizinische Prävention und Therapie, sondern auch um den sozialen Umgang mit diesen Phänomenen. Die psychologische Medizin hat sich längst zum Erfüllungsgehilfen einer Bewegung gemacht, die kognitive Schwächen an Lebensanfang und –ende übermäßig pathologisiert und therapiert. Dem kommt zupass, dass sie sich einem Materialismus verschreibt, der sich nicht nur neurobiologisch, sondern auch psychopharmakologisch und ökonomisch zeigt. ADHS- und Demenzforschung folgen überwiegend der Hinforschung, besonders im Sinne von Neurofeedback und Kognitionstraining, und unter Vernachlässigung geisteswissenschaftlich fundierter psychotherapeutischer Ansätze. Motor von Forschung und öffentlicher Wahrnehmung sind nicht zuletzt pharmakologische Optionen, die im Hinblick auf ADHS besorgniserregend inflationär ergriffen werden und für die Demenz im Grunde noch ausstehen, aber sehnsüchtig erwartet werden. Letztlich geht es beim Kult um das Kognitive um die Angst vor Kontrollverlust. Die Erkenntnis, mit unserem Denken nicht die gesamte Lebensspanne kontrollieren zu können, kränkt uns Menschen offensichtlich maßlos. Am Ende drückt sich das auch darin aus, dass wir mit Reproduktionsmedizin und Sterbehilfe auch das noch krampfhaft in den Griff zu bekommen versuchen.

Die beschriebene Entwicklung folgt letztlich dem Impuls, das Erwachsenenleben im Vollbesitz kognitiver Fähigkeiten in der Lebensspanne soweit wie möglich nach vorne und hinten auszudehnen. Unabhängig von der Frage nach einer ökonomischen Logik, erscheint mir dies als ein Irrweg. Bei heranwachsenden Menschen baut die geistige Entwicklung neuropsychologisch darauf auf, dass körperliche und emotionale Entwicklungsaufgaben zuvor bewältigt worden sind. Und für das höhere Lebensalter macht es einen Sinn, wenn unser Gedächtnis für Neues nachlässt zugunsten einer Konzentration auf das Vergangene und einer Besinnung auf das Hier und Jetzt der verbliebenen Zeit. Dass das Denken seine Grenzen hat, ist physiologisch und nicht pathologisch. Damit will ich leidvolle Manifestationen von ADHS und Demenz nicht romantisieren. Aus meiner Sicht rührt allerdings ein nicht unerheblicher Teil des Leidens an diesen Phänomenen daher, dass wir das Kognitive überbewerten und seine Beeinträchtigung zu sehr fürchten. Dies führt erstens dazu, dass wir diese Erkrankungen zu früh und zu häufig diagnostizieren. Und zweitens, dass wir zu viele Ressourcen darauf verwenden, uns und unsere Angehörigen einer kognitiven Norm anzugleichen, anstatt individuelle Entwicklungsspielräume zu schaffen, die den unterschiedlichen Bedürfnissen der Jungen und Alten gerecht werden.

Im Kampf der Erwachsenen gegen die ADHS-Diagnose ihrer Kinder und im Kampf der erwachsenen Kinder gegen die Demenz-Diagnose ihrer Eltern geraten bisweilen ganz einfache zwischenmenschliche Perspektiven aus dem Blick. Wenn das Umfeld eines Kindes zu viel damit beschäftigt ist, es einer kognitiven Norm anzugleichen, wird ihm nicht ausreichend vermittelt, bedingungslos geliebt und willkommen zu sein. Und wenn sich im Umgang mit Demenzkranken alles um kognitive Defizite dreht, verpassen die Angehörigen die Chance, sich mit den Ressourcen der Betroffenen zu verbünden und darüber auf sie zu beziehen. Menschlich hapert es bei der Begrüßung und Verabschiedung im Leben. Vermutlich kann nur wer sich als erwachsener Mensch sein sinnliches Erleben im Hinblick auf Natur und Kultur erhält, ein guter Begleiter für Junge und Alte sein. Wahrscheinlich ist das auch die beste Vorbereitung auf die eigene Demenz.

____________________

Literatur

Externe Links

____________________

Abbildungsnachweis

© Bert te Wildt 2014 (private Aufnahme)

Empfohlene Zitierweise

te Wildt, Bert: Leiden am Kult des Kognitiven. In: Public History Weekly 2 (2014) 41, DOI dx.doi.org/10.1515/phw-2014-2709.

Copyright (c) 2014 by De Gruyter Oldenbourg and the author, all rights reserved. This work may be copied and redistributed for non-commercial, educational purposes, if permission is granted by the author and usage right holders. For permission please contact: julia.schreiner (at) degruyter.com.

The post Suffering from the collective cult of cognition appeared first on Public History Weekly.

Quelle: http://public-history-weekly.oldenbourg-verlag.de/2-2014-41/suffering-collective-cult-cognition/